Automatischer Web-Crawler

Automatisierte Analyse von Internetseiten

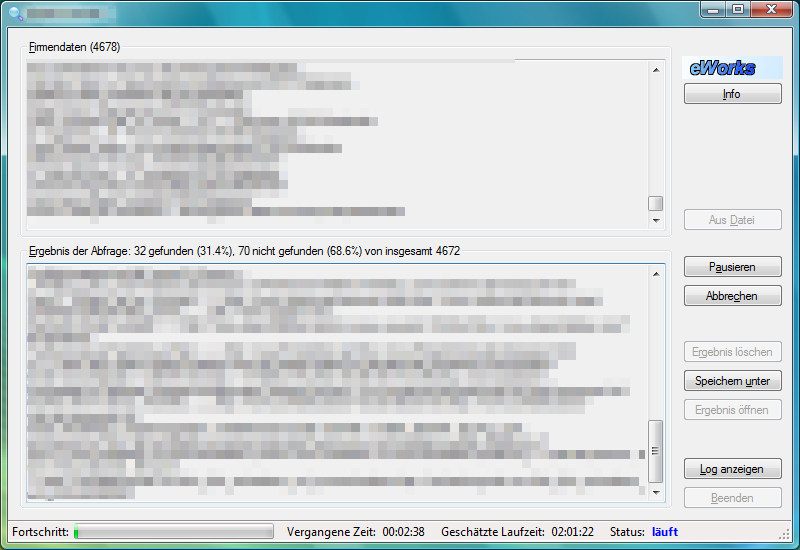

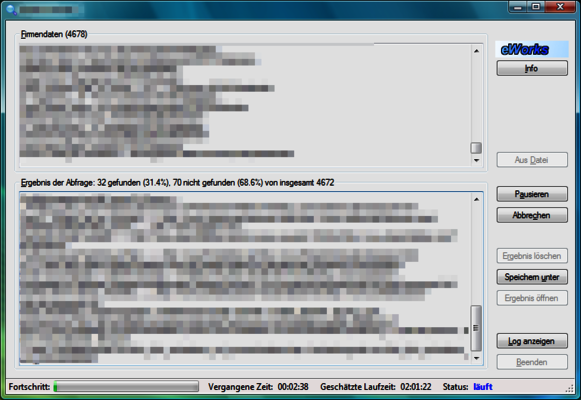

eWorks hat im Auftrag eines Informationsdienstleisters einen Web-Crawler zur automatisierten Analyse von Internetseiten geplant und entwickelt. Zielsetzung waren die Erhöhung der Datenqualität und der Verarbeitungsgeschwindigkeit bei gleichzeitiger Reduzierung des manuellen Arbeitszeitaufwandes.

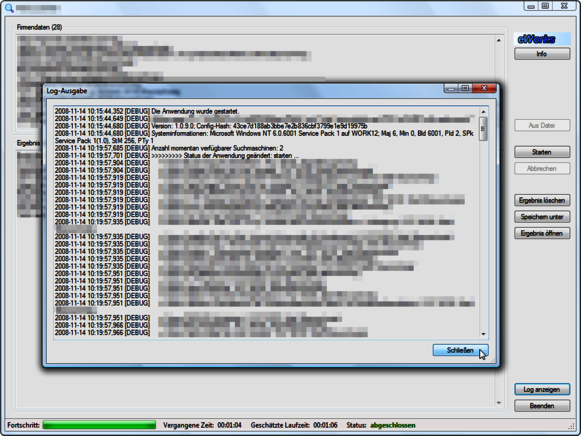

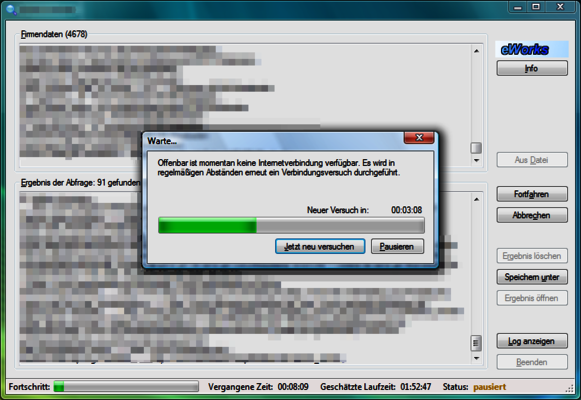

Die Aufgabenstellung sah vor, basierend auf Datensätzen einer Eingabe-Datenbank maschinelle Internet-Recherchen durchzuführen, und die gefundenen Resultate in einer Ergebnis-Datenbank zu speichern. Der entwickelte Web-Crawler löst die Aufgabe, indem er in mehreren Phasen nach stets präziser werdenden Informationen sucht. In jeder Phase werden dabei die als wenig erfolgsversprechenden Ergebnisse eliminiert, mit den übriggebliebenen Ergebnissen wird in der nächsten Phase fortgefahren. Die Interpretation und Verdichtung der Ergebnisse erfolgt durch leistungsfähige, heuristische Algorithmen, die selbst entwickelt und in den Web-Crawler eingebaut worden sind.

eWorks hat den Web-Crawler konzipiert, mit C# und Microsoft.NET als Multi-Threading-WinForms-Anwendung entwickelt und dem Auftraggeber übergeben. Dieser setzt den Web-Crawler seitdem regelmäßig ein, und reduziert signifikant seinen Arbeitsaufwand für bislang manuell durchgeführte Recherchen bei gleichzeitiger Steigerung des Durchsatzes.